Tushunarli sun'iy intellekt - Explainable Artificial Intelligence

Ikboljon Sobirov

Sunʼiy intellekt (SI) modellari "qora quti" deganimizda bir oz tushunmovchilik kelib chiqadi. Ularni butunlay tushunmaymiz deyish notoʻgʻri boʻladi. Modelning har bir boʻlagini tushungan holda, nima qilishini bilgan holda qoʻshamiz yoki olib tashlaymiz. Qiladigan har bir hisob kitobini bilamiz va toʻliq tushunamiz.

Tushunmaydigan narsamiz bu nega aynan bir qarorni ikkinchisidan koʻra afzalroq deb koʻradi. Misol uchun, agar ChatGPT'dan siz "sen kimsan?" deb soʻrasangiz, nega "men ChatGPT'man", deydi? Va nega "men GPT modeli uchun yaratilgan chat qilish quroliman" demaydi? Yoki aksi.

Bu kabi qarorlarini nega qaror qilganini tushunishlik juda koʻp sohalarda, shu bilan tibbiyotda ham ahamiyati katta. Chunki, model chiqargan qarorni nima uchunligini tasdiqlab berish kerak.

Tushunarli sun’iy intellekt - TSI (Explainable AI - XAI) aynan shu savolga javob beruvchi SI'ning bir boʻlimi hisoblanadi. Rasman, TSI - SI tizimlarining qaror qabul qilish jarayonini insonlar uchun tushunarli qilish uchun qo‘llaniladigan usul va texnikalardan iborat. SI modellari, xususan, chuqur o‘rganish modellari tobora murakkab va tushunarsiz (“qora quti”) bo‘lib borayotgani sababli, bu modellar qanday qilib o‘z bashoratlari yoki qarorlariga kelayotganini aniqlashtirish ehtiyoji ortib bormoqda. TSI ushbu ehtiyojni qondirish uchun SI tizimlarining ichki ishlarini tushunishga yordam beradi.

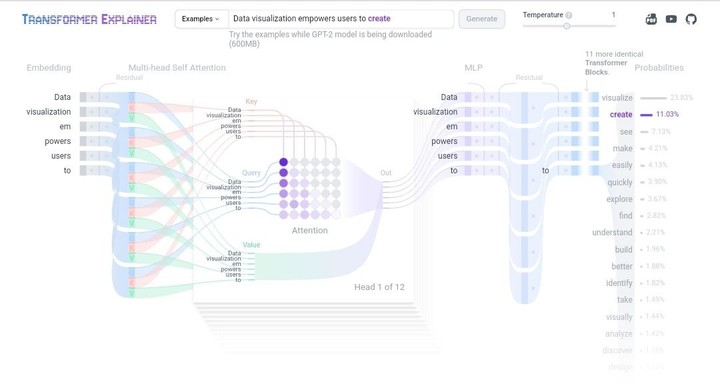

Bu sohada ham anchagina ish qaynoq va doimiy talab ostida. Bunda modelning ichiga qaragan holda, aynan bir qaror chiqarganda, modelning ichidagi har bir boʻlak nima bilan mashgʻul ekanligi oʻrganiladi. Ushbu havolada (https://poloclub.github.io/transformer-explainer/) transformerlarning qaror qilishi tushuntirilib berilgan. Juda chiroyli ish qilingan ekan. Oʻzingiz oʻynab koʻrsangiz boʻladi.

Oxford, UK

16 August 2024

Comments